Biomedical Signal Processing Based on Artificial Intelligence: 인공지능 기반 생체신호처리

본문

최근 딥러닝을 필두로 하는 인공지능 기술이 활발하게 연구되면서 인공지능 기술을 생체신호 처리 및 분류에 활용하려는 연구가 활발해지고 있다. 한양대학교 계산지능 및 뇌공학 연구실에서는 다양한 딥러닝 기술을 이용하여 생체신호 기반 인간-컴퓨터 인터페이스, 뇌-컴퓨터 인터페이스, 디지털 헬스케어 연구를 선도적으로 수행하고 있으며 생체신호 처리를 위한 새로운 딥러닝 기법도 개발하고 있다. 아래에 본 연구실에서 수행한 대표적인 연구 성과 사례를 나열하였다.

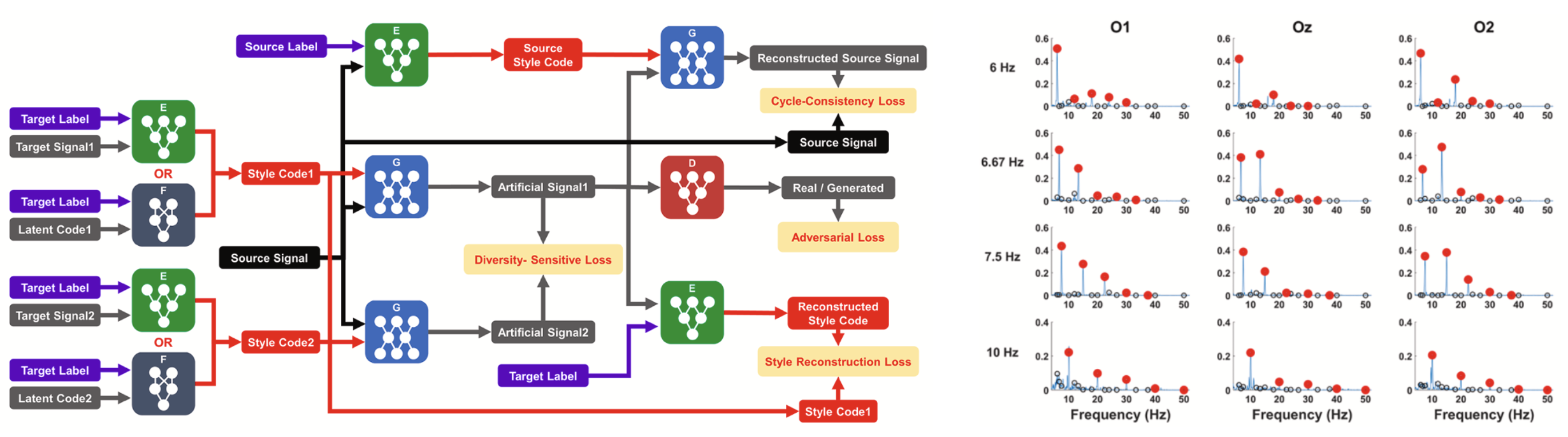

신경 스타일 전이(Neural Style Transfer) 기술은 2015년 딥러닝과 예술의 만남으로 큰 화제를 불러왔던 기술로, AI가 고흐나 렘브란트의 작품에서 화풍을 학습하고 임의의 사진을 해당 화가들이 그린 그림처럼 변환시키는 기술을 의미한다. 해당 기술을 음성 신호에 적용하면 자신의 목소리를 특정 연예인의 목소리로 변조하는 것도 가능하다. 신경 스타일 전이 기술은 이처럼 이미지나 음성 변환에 주로 활용됐고, 뇌에서 발생하는 생체신호인 뇌파에 적용된 적은 없었다. 계산지능 및 뇌공학 연구실에서는 영상변환분야에 쓰이는 StarGAN 모델에 기초해 뇌파 신호변환을 가능하게 하는 새로운 신경망 S2S-StarGAN 모델을 개발했다. 본 연구실에서는 최초로 인공지능 기술을 이용해서 휴식상태에서 측정한 16초의 짧은 뇌파 신호를 정상상태시각유발전위(SSVEP)라는 특수 뇌파로 변환하는 데 성공했다. S2S-StarGAN 모델로 구현한 SSVEP 기반 BCI를 사용하면 기존방식 대비 평균 3.4%p, 최대 10%p 이상의 정확도 향상이 가능함을 확인했다. 또한 기존에는 BCI 시스템을 사용하기에 앞서 5분 이상의 개인별 데이터 수집 과정이 필요했던 데 비해, 새로운 방법을 사용할 경우 15초 내외의 휴식상태 뇌파만 수집하면 되기 때문에 BCI 사용 편이성을 크게 향상시킬 수 있을 것으로 예상된다 (Kwon and Im, Expert Syst. Appl., 2022). 현재 본 연구실에서는 SSVEP 이외에도 다른 뇌파로 데이터를 전이하는 기술을 개발하고 있는데 특히 건식(dry) 환경에서 측정된 뇌파 신호를 습식(wet) 환경에서 측정된 뇌파로 변환하는 기술도 개발하고 있다. 아래 왼쪽 그림은 S2S-StarGAN 모델을 학습하는 과정을 나타내고 있으며 오른쪽 그림은 제안된 모델을 이용해서 생성한 인공 뇌파신호의 사례를 보여주고 있다.

<(왼쪽) CoNE 랩에서 개발한 S2S-StarGAN 모델의 학습 과정, (오른쪽) 인공적으로 생성한 SSVEP 뇌파 신호의 주파수 분석 결과>

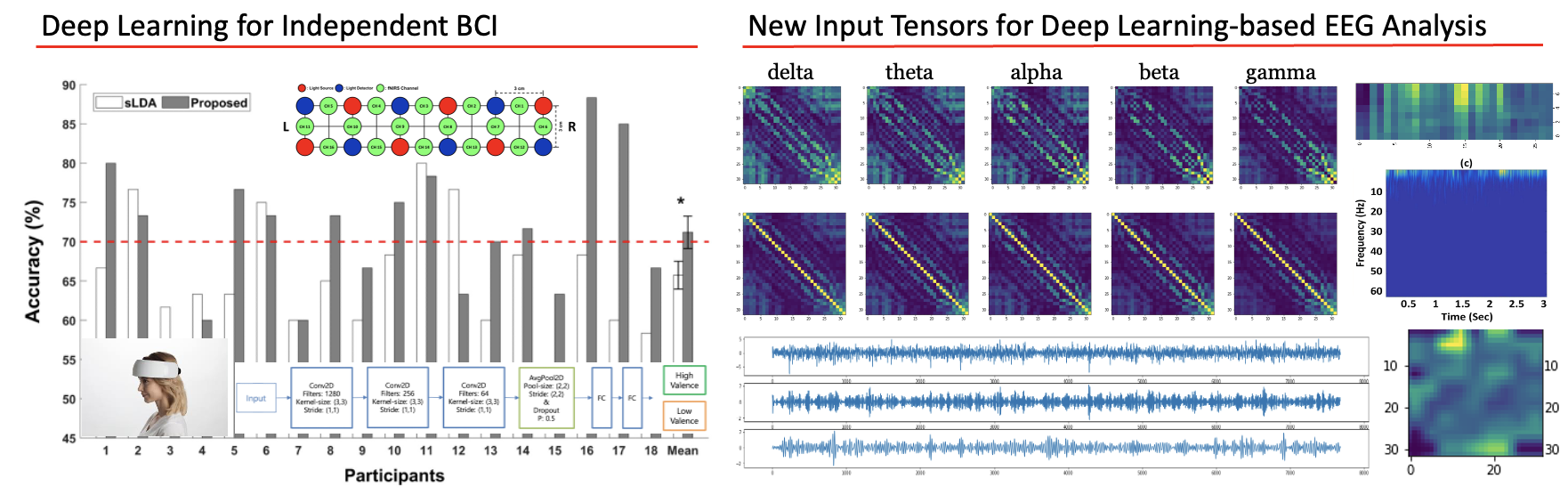

한양대 계산지능 및 뇌공학 연구실에서는 다양한 신경신호 기반 뇌-컴퓨터 인터페이스의 성능을 향상시키기 위한 새로운 딥러닝 방법을 개발하고 있다. 예를 들어 2021년에는 기능적 근적외선분광(fNIRS) 기반 뇌-컴퓨터 인터페이스를 구현할 때, 개별 사용자의 훈련 없이 다른 사용자의 데이터로 학습한 딥러닝 모델을 적용하여 높은 정확도로 인지 과제 분류를 가능하게 하는 딥러닝 모델을 개발하였다 (Kwon and Im, Front. Hum. Neurosci., 2021). 최근에는 뇌파 기반 뇌-컴퓨터 인터페이스의 성능을 향상시킬 수 있는 새로운 방법으로 원 신호(raw data)와 그 데이터의 위상 정보만을 추출한 시계열 데이터를 함께 사용하는 딥러닝 모델을 개발하여 기존의 원 신호만 사용하는 방식 대비하여 우수한 분류 성능을 보이기도 했다 (Kim et al., Comput. Biol. Med., 2024). 또한 뇌파 등 신경신호에 딥러닝을 적용할 때 일반적으로 문제가 되는 데이터의 부족 문제를 해결하기 위하여 새로운 데이터 증강(data augmentation) 기법을 개발하고 다수의 데이터 증강 결과를 혼합 사용하는 하이브리드 데이터 증강 기술도 개발하였다. 이 외에도 뇌-컴퓨터 인터페이스의 정확도를 향상시킬 수 있는 새로운 구조를 다수 제안하였는데 예를 들어 양쪽 귀 부위에서 측정된 뇌파를 이용한 수동형 BCI의 성능을 향상시키기 위해 cross-attention 개념을 도입한 DeepAttNet 등이 대표적이다 (Hyung et al., Front. Hum. Neurosci., 2025).

<(왼쪽) 딥러닝을 이용한 zero-trainig fNIRS 기반 BCI 구현, (오른쪽) 뇌파의 딥러닝 분석을 위한 새로운 입력 텐서 탐색 연구>

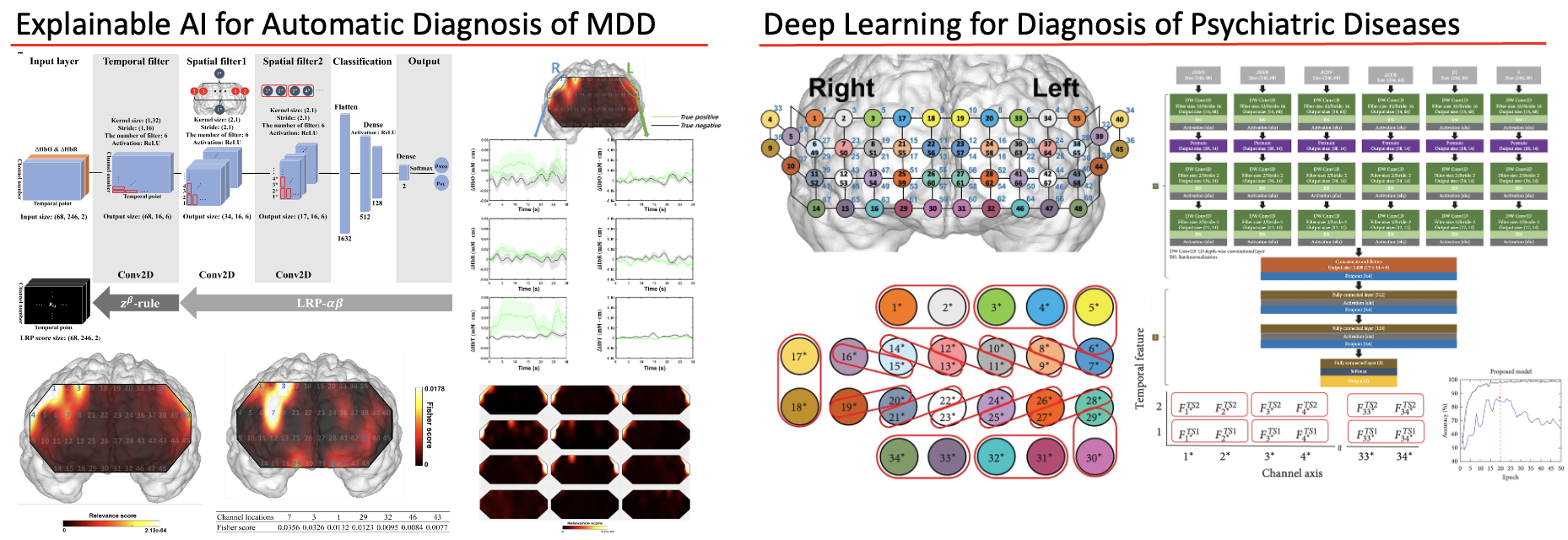

한양대 계산지능 및 뇌공학 연구실에서는 다양한 최신 딥러닝 기술을 활용하여 조현병, 우울증, 양극성장애 등 다양한 정신질환을 높은 정확도로 자율진단할 수 있는 새로운 인공지능 기반 신경신호 분석 기술을 개발하고 있다. 특히 최근에는 뇌파 데이터를 이용하여 양극성 장애와 주요 우울장애를 감별진단하는 딥러닝 기술을 개발하였으며 약물 치료의 예후를 예측하는 인공지능 모델도 개발하는 데 성공하였다. 또한 설명가능한 AI 기술을 이용하여 정신질환을 진단하는 기술을 개발(왼쪽 그림)하여 기존의 기계학습 기반 자율진단보다 높은 정확도를 획득하면서도 기계학습에서 주로 사용된 특징점 분포와 유사한 특징점 지도를 도출하는 데 성공하였다. 또한, 기존에 신경신호의 딥러닝 기반 분석을 위해 활용되던 딥러닝 모델보다 높은 정확도를 획득할 수 있는 새로운 구조를 다수 제안하였다. 예를 들어 fNIRS의 좌-우 비대칭성 특성을 고려하는 새로운 채널 임베딩 구조를 가지는 신경망을 제안하여 우울증 진단 정확도를 획기적으로 향상하였다 (Lee et al., Dep. Anxiety, 2024, 오른쪽 그림).

<(왼쪽) 설명가능한 AI(XAI)를 이용하여 주요우울장애를 자율진단, (오른쪽) fNIRS를 이용한 정신질환 자율진단을 위한 새로운 딥러닝 모델>

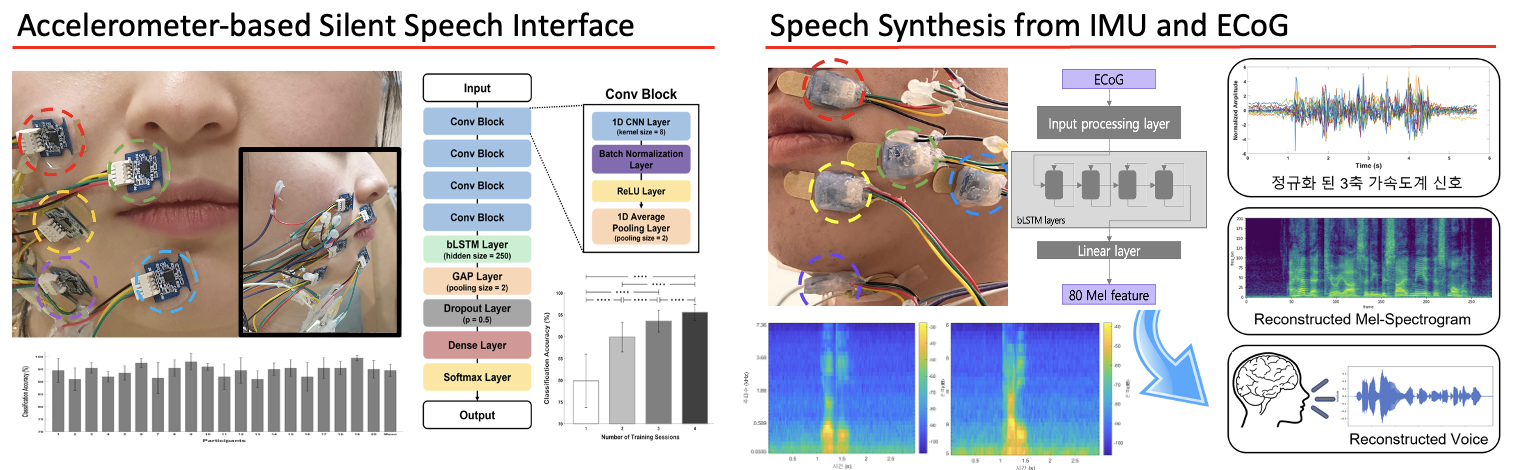

소리를 이용하는 음성 발화 인식 기술은 이미 인공지능 스피커 등 실생활에서 널리 활용되고 있다. 본 연구실에서는 실제 발화를 하지 않고 입모양만 움직일 때 발생하는 다양한 생체신호(근전도, 3축 가속도계)를 딥러닝을 이용하여 분석함으로써 무음 음성 인식(Silent Speech Recognition) 시스템을 구현하고 있다. 특히, 3축 가속도계를 이용하여 무음 음성 인식 시스템을 개발한 것은 본 연구실이 세계 최초이며 이 연구 결과는 다학제 컴퓨터공학 분야 상위 5% 학술지인 Engineering Applications of Artificial Intelligence 저널에 게재되었다 (Kwon et al., EAAI, 2023; 왼쪽 그림). 최근에는 가속도계를 포함한 IMU 정보로부터 음성을 합성하는 연구를 활발하게 진행하고 있으며 무음 음성 인식에서 한 발 더 나아가 생각만으로 음성을 합성하는 상상 발화 인식(Imagined Speech Recognition) 기술도 개발 중에 있다.

<인공지능을 이용한 침묵/상상 발화 인식 연구 사례: (왼쪽) 가속도계를 이용한 무음 발화 인식, (오른쪽) IMU와 ECoG를 이용한 음성 합성>

현재 본 연구실에서는 상기 연구 사례 이외에도 생체신호 기반 차량 멀미 인식, VR 환경에서의 사이버 멀미 인식, 뇌파를 이용한 주의 집중도 분석, 뇌파 및 영상 기반 학습 중 집중 상태 분석 등에 최신 딥러닝 알고리즘을 적용하는 연구를 수행하고 있으며 논문이 게재 되는대로 본 홈페이지를 통해 소개할 계획이다.