본문내용

Research Topics

Biosignal-Based Human-Computer Interfaces: 생체신호 기반 인간-컴퓨터 인터페이스 및 뉴로마케팅

|

생체신호 기반 인간-컴퓨터 인터페이스 본 연구실에서는 뇌-컴퓨터 인터페이스(BCI) 뿐만 아니라 뇌파 이외의 다양한 생체신호들을 이용하여 인간과 컴퓨터(또는 기계)가 소통할 수 있는 새로운 인터페이스(Neo-Interface) 시스템들을 개발하고 있다. 이 기술들은 장애인의 의사소통을 보조하는 보조기술(assistive technology)로 활용될 수 있을 뿐만 아니라 가상현실(VR), 증강현실(AR) 시대에 새로운 메타버스 서비스를 위한 입력 디바이스로서 활용될 가능성을 보여주고 있다. 한 편, 본 연구실에서는 생체신호를 이용한 인간-컴퓨터 인터렉션의 응용 분야로서 뉴로마케팅(Neuromarketing) 분야도 연구하고 있는데, 주로 기업들과의 협업을 통해 뇌파를 비롯한 다양한 생체신호가 제품의 디자인, 상품이나 기업의 로고 디자인 등에 실질적으로 활용될 수 있도록 다양한 기술을 연구 개발하고 있다. 아래에 본 연구실의 연구 결과들을 일부 나열하였다.

2020년 이후 종료된 생체신호 기반 HCI 연구과제 목록

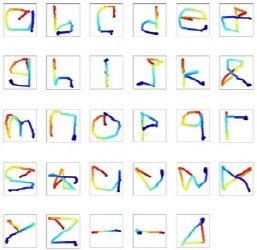

안구전도 신호 기반 인간-컴퓨터 인터페이스 안구전도(EOG)를 이용한 안구 마우스 및 문자 인식 시스템 안구의 전면은 양의 포텐셜을, 후면은 음의 포텐셜을 가지고 있어서 눈동자가 움직이면 눈 주변부위에 부착된 전극에 전위 변화가 측정된다. 이러한 원리를 이용해서 한양대 계산신경공학연구실에서는 카메라를 사용하지 않고도 눈동자의 움직임을 추적할 수 있는 안구마우스를 최초로 개발하였다. 기존의 안구마우스는 위-아래-좌-우 정도의 이산(discrete) 정보만을 추출하는데 그쳤으나, 새롭게 개발한 안구마우스는 연속적인 눈동자의 움직임을 추적하고, 눈동자 움직임으로 문자를 쓰도록 하여, 사용자가 어떤 문자를 눈으로 썼는지를 인식하는 새로운 방식을 고안하였다 (Lee et al., IEEE TNSRE, 2017). 본 연구실에서는 안구마우스 개발 과정에 가로방향 및 세로방향 안구전도 성분 사이의 간섭을 제거하기 위한 새로운 방법을 제안(Chang et al., Sensors, 2016)하고 눈깜빡임을 자동으로 인식하는 새로운 방법을 개발(Chang et al., Physiol. Meas., 2016)하는 등 여러 가지 새로운 방법들을 개발하여 반영하였다. 개발된 안구마우스는 사지마비 장애인을 대상으로 적용하여 우수한 결과를 도출하였으며 VR, AR 시스템과의 접목을 위한 연구를 진행하고 있다 (예시: Ha et al., Front. Neuroinform., 2022). <왼쪽 그림: 눈으로 쓴 글씨를 안구전도로부터 복원한 결과, 오른쪽 그림: 눈 글씨 실시간 인식 프로그램 실행 모습 (Lee et al., 2016)> 오른쪽 그림을 클릭하시면 시연 동영상을 볼 수 있습니다 (wmv file).

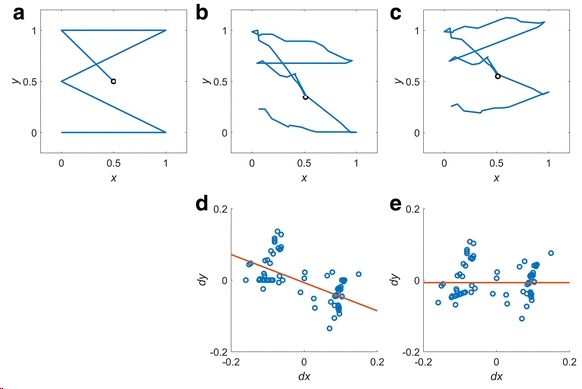

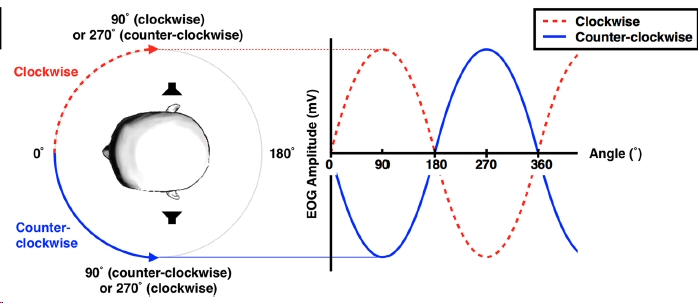

안구전도(EOG) 신호를 이용한 사지마비 장애인의 의사전달 시스템 본 연구실은 안구전도 신호 분석 원천 기술을 바탕으로 하여 사지마비 장애인의 의사전달을 위한 새로운 시스템을 다수 개발하여 국제 저명 학술지에 다수의 논문을 게재하였다. 우선 안구 마우스 기술을 바탕으로 한 눈으로 그린 패턴 인식 기술을 이용하여 안구 운동 기능이 일부 소실된 루게릭병에 걸린 환자가 90% 이상의 정확도로 10가지 의사를 표현하는 시스템을 구현하는 데 성공하였다(Chang et al., J. Neuroeng. Rehabil., 2017). 아래 왼쪽 그림은 이 연구에서 새롭게 개발한 눈 글 패턴 보정 알고리즘을 보여주고 있다. 또한 본 연구실에서는 서로 다른 방향으로 회전하는 두 개의 소리 자극 중에서 특정 소리 자극에 집중할 경우 특정한 위상을 가지는 안구전도 신호가 측정된다는 점에 착안하여 소리 자극에 대한 반응을 안구전도로부터 측정하여 사지마비 장애인의 이진 의사 전달에 활용하는 새로운 방법론을 제안하였다(Kim et al., Sci. Rep., 2018). 아래 오른쪽 그림은 제안된 방법의 개념을 나타내고 있으며, 이 방법을 중증 루게릭 환자에게 적용한 결과 90% 이상의 높은 정확도를 얻을 수 있었다.

<안구전도를 이용한 중증 사지마비 장애인의 의사 전달을 위한 새로운 보조 의사소통 시스템 사례: Chang et al., 2017 & Kim et al., 2018>

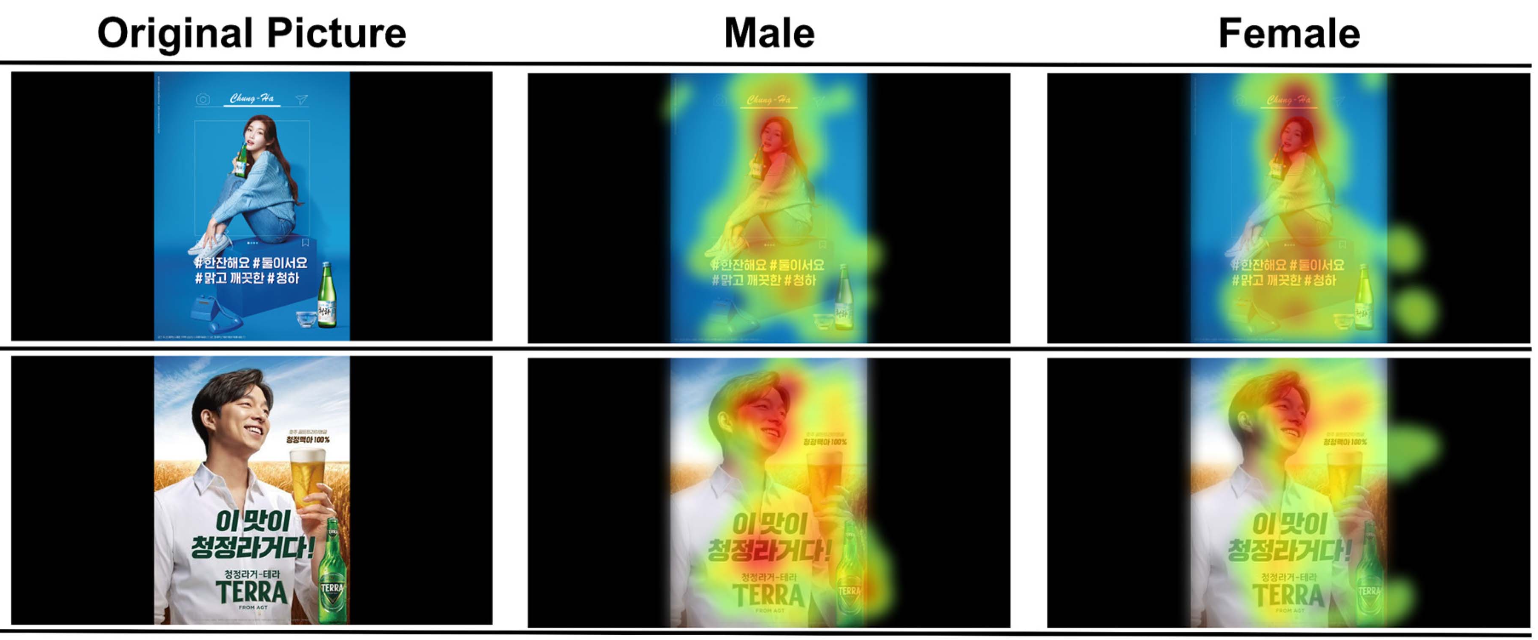

안구전도 기반 안구 추적 기술을 이용한 광고 평가 뉴로마케팅 시스템 한양대 계산지능 및 뇌공학 연구실에서는 본 연구실에서 최초로 개발한 안구전도 기반 안구 추적 기술을 이용하여 포스터 형태의 광고나 제품 사진을 볼 때 시선이 주로 머무는 위치를 히트맵(heat map) 형태로 표현할 수 있는 광고 평가 뉴로마케팅 시스템을 최초로 개발하였다 (Ha et al., IEEE Trans. Instrum. Meas., 2022). 기존에 카메라를 이용한 안구추적 시스템은 가격이 비싸고 시야를 방해하는 단점이 있었으나 안구전도 기반의 안구추적 시스템은 100$ 이하의 저렴한 가격에 카메라 기반 안구추적과 동등한 수준의 결과를 도출할 수 있어 보급형 뉴로마케팅 시스템으로 활용이 가능할 것으로 기대된다. 아래 그림은 개발한 안구전도 기반 안구추적을 실제 광고 평가에 적용한 결과이다.

<안구전도를 이용한 광고 평가 뉴로마케팅 적용 사례 - 동일한 광고를 보았을 때 남녀의 시선 추적 히트맵 (Ha et al., 2022)>

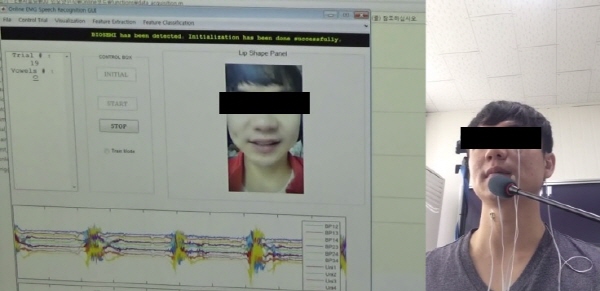

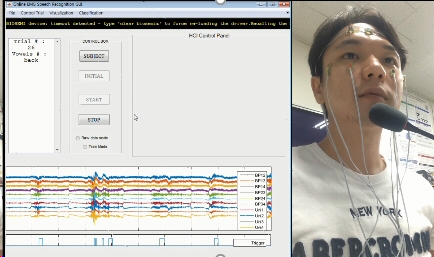

근전도 신호 기반 인간-컴퓨터 인터페이스 안면부 근전도 신호를 이용한 AI 기반 Slient Speech Recognition 공공장소에서 사적인 대화를 나눌 때, 목소리가 들리지 않으면서 내 의사를 상대방에게 전달하면 좋겠다는 생각을 한 번 쯤은 한 적이 있었을 것이다. 한양대 계산지능 및 뇌공학연구실에서는 얼굴에 부착한 근전도(EMG - 근육의 움직임이 만들어 내는 전기신호) 신호를 측정하여 사용자의 입모양과 단어를 실시간으로 인식하는 시스템을 구현하였다. 이 시스템에서는 7개 단어 또는 입모양을 90%에 달하는 높은 정확도로 실시간 분류하는데 성공하였으며(아래 왼쪽 동영상), 이 시스템을 발전시켜서 VR 환경에서 입모양만으로 사용자의 의도를 인식하는 시스템을 (주)삼성전자와 함께 개발하였다 (아래 오른쪽 동영상) (YouTube Link) 최근에는 VR환경에서 측정한 안면부 근전도 신호에 LSTM 등 딥러닝 기술을 적용하여 적은 수의 트레이닝 데이터 만으로 높은 분류 정확도를 얻을 수 있는 기술을 개발하였다 (Cha et al., Virtual Reality, 2022). <실시간 slient speech recognition 데모 동영상(그림 클릭): (좌) 안면부 EMG 전극, (우) VR 환경 가정한 EMG 전극 배치>

<VR 환경에서 측정한 안면부 근전도 신호에 딥러닝 기술을 적용하여 실시간 무음 발화를 인식하는 시스템 (YouTube Link)>

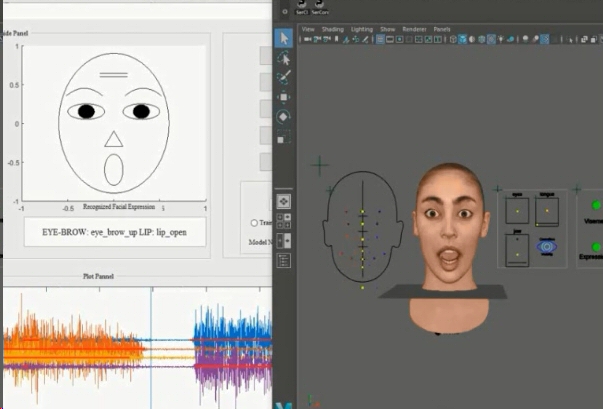

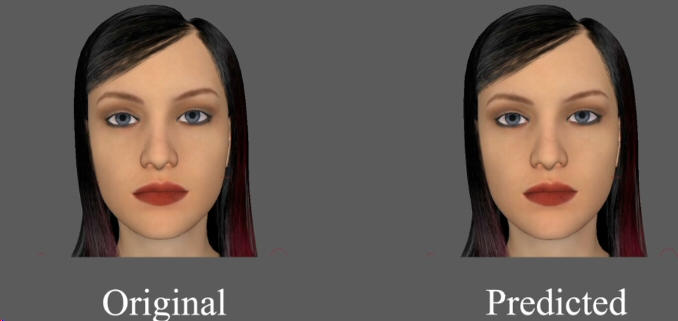

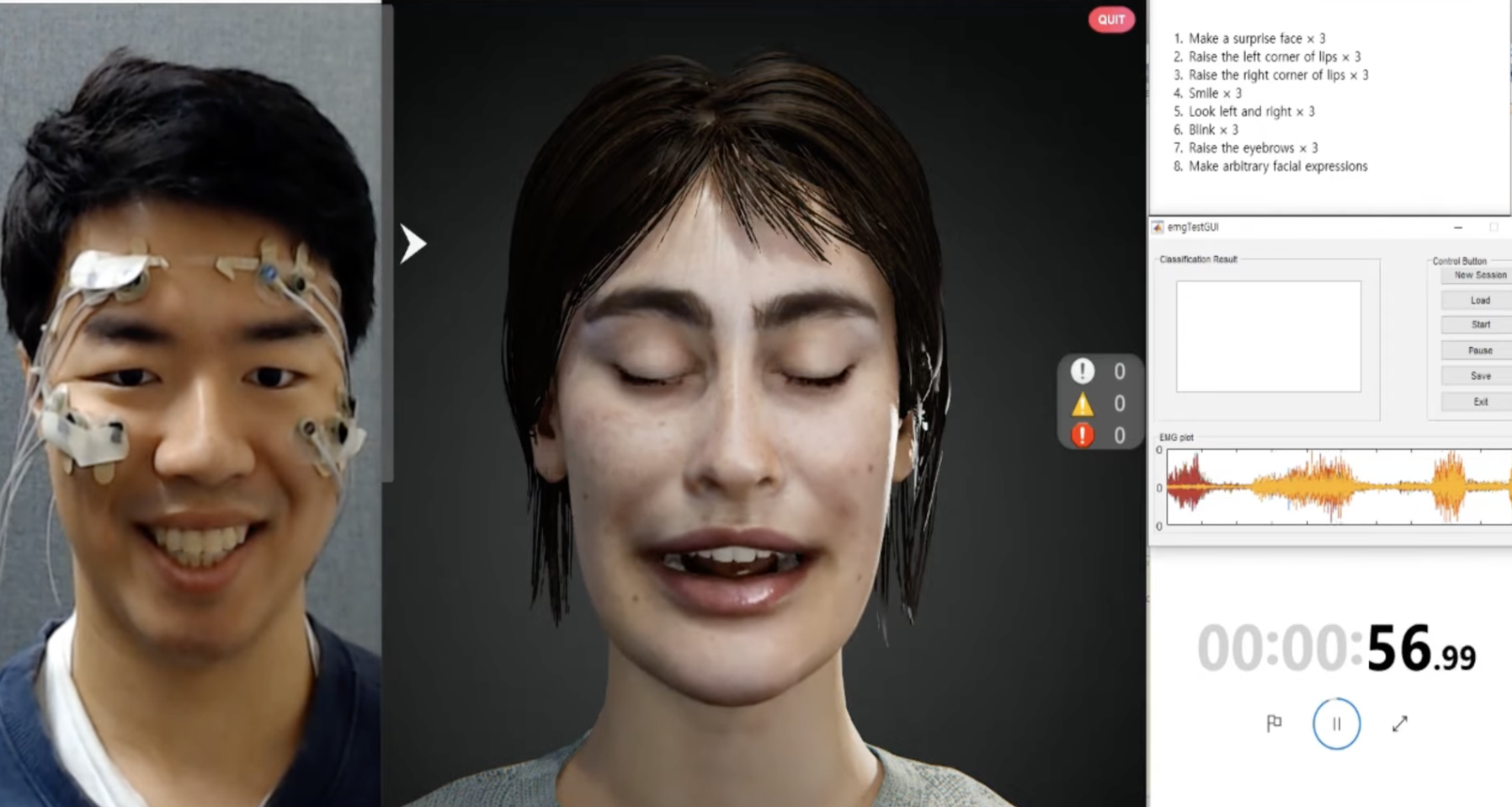

VR 메타버스 환경에서 근전도 신호를 이용한 사용자의 표정 인식 가상현실과 실제 세계 사이의 경계가 허물어진 미래 세상을 보여주는 영화 <레디 플레이어 원(Ready Player One)>을 보면 VR 사용자의 표정이 가상현실 속의 아바타 표정에 그대로 반영되는 설정이 등장한다. 이처럼 보다 실제적인 VR 환경 구현을 위해서는 VR 환경 내에서 사용자의 표정을 인식하여 표현하는 것이 매우 중요한 기술인데, 현재까지는 주로 얼굴 앞에 위치한 카메라를 이용하는 것이 보통이었다. 본 연구실에서는 VR에 사용하는 헤드마운트 디스플레이(HMD)가 눈 주위 부분과 닿는 부분이 있다는 점에 착안하여 눈 주위에서 측정되는 근전도(EMG) 신호를 이용한 표정인식 시스템을 구현하였다. 사용 전 4-5회의 트레이닝 과정을 거쳐야 하는 기존 시스템과 달리 본 연구실에서 개발한 시스템은 단 1회의 표정 등록만으로도 90% 이상의 높은 정확도로 10개 내외의 서로다른 표정을 인식하고 이를 아바타의 표정에 반영하는 기술을 개발하였다 (Cha et al., IEEE Access, 2019). 오른쪽 그림에 링크된 동영상은 딥러닝 알고리즘인 bidirectional LSTM을 이용하여 자연스러운 얼굴 표정 변화를 연속적으로 인식할 수 있게 한 결과물이다. 왼쪽에 있는 아바타 얼굴 표정은 카메라를 이용하여 표정 변화를 감지한 것이며 오른쪽에 있는 아바타 얼굴 표정은 안면부 근전도 신호를 이용하여 표정 변화를 연속적으로 추정한 결과이다. 아래에 있는 YouTube 동영상 링크는 여러 사용자의 데이터를 활용해 개별 사용자의 표정 인식 정확도를 향상시키기 위해 adaptive learning 기법을 적용한 결과를 보여주고 있다 (Cha and Im, Virtual Reality, 2022) <(왼쪽 그림) 실시간 근전도 측정 기반 아바타 표정 변화 프로그램 구동 모습 (그림 클릭하면 유튜브 연결), (오른쪽 그림) 딥러닝을 이용한 자연스러운 얼굴 표정 인식: 그림을 클릭하면 시연 동영상을 볼 수 있습니다 (wmv 파일)>

<VR 환경에서 측정한 안면부 근전도 신호를 이용하여 실시간으로 얼굴 표정을 인식하는 시스템 데모 (YouTube Link)>

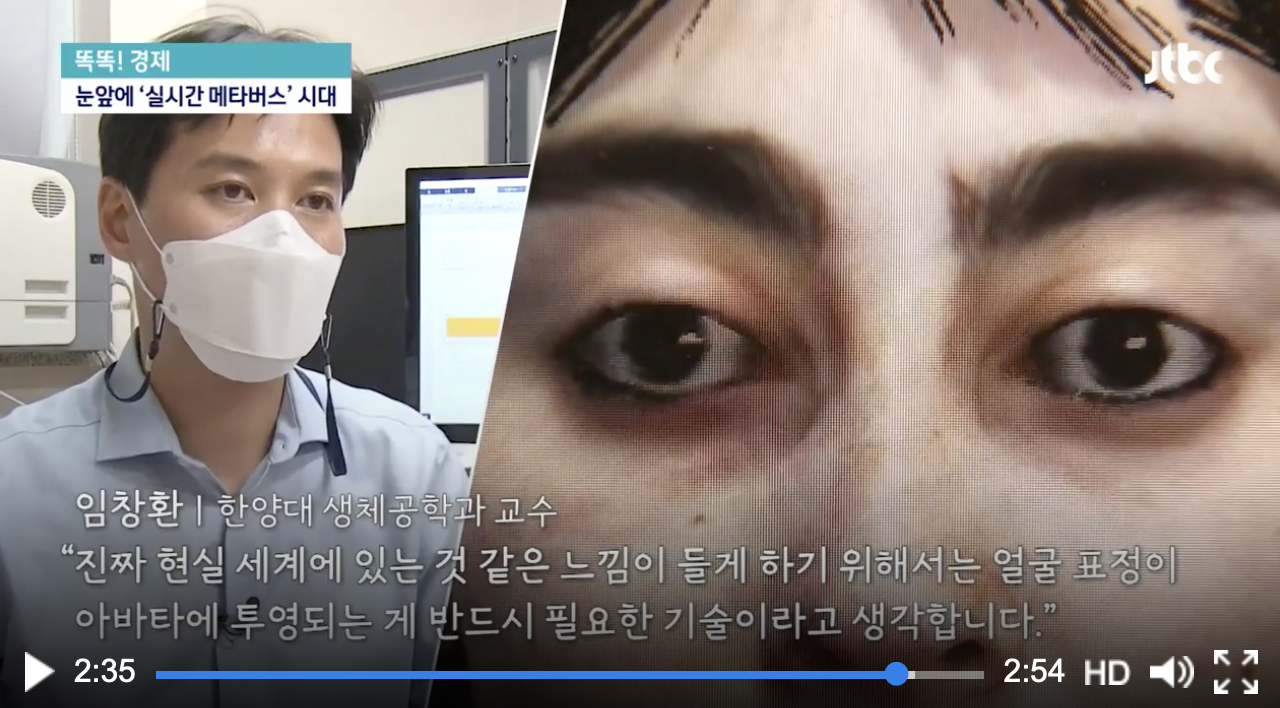

최근 연구에서는 안면부 근전도 기반 얼굴 표정 인식의 실용성을 향상시키기 위한 연구를 지속적으로 수행하고 있는데, VR 헤드셋을 탈부착할 경우 미세하게 전극의 위치가 변화하더라도 기존 데이터베이스를 이용해서 높은 정확도를 얻어낼 수 있는, 기계학습 adaptive learning 기술을 개발하였다 (Cha and Im, Virtual Reality, 2023). 또한, 안면부 근전도뿐만 아니라 동일 전극에서 측정한 안구전도 신호를 동시에 활용하고 단순 표정의 분류에서 더 나아가 표정의 연속적인 추정이 가능한 기술을 개발하여 통합 얼굴 표정 캡춰 시스템을 구현하였다.

<(왼쪽) 근전도, 안구전도 융합 얼굴 표정 캡춰 시스템 시연(그림 클릭하면 유튜브 연결), (오른쪽) JTBC 방영 영상(그림 클릭)>

새로운 메타버스-게임 인터페이스를 위한 근전 인터페이스 개발 한양대학교 계산지능 및 뇌공학 연구실에서는 기존에 의수나 의족의 제어를 위해 연구되어 오던 근전 인터페이스(myoelectric interface)를 AR이나 VR의 제어 인터페이스나 게임 인터페이스로 활용하기 위한 연구를 수행하고 있다. 근전 인터페이스는 딥러닝 등 기계학습 기술을 적용하여 근전도 신호를 실시간으로 분류함으로써 기존의 핸드 콘트롤러를 대체할 수 있는 가능성을 보여주었다. 또한 보다 인터랙티브한 게임 UI를 구현하기 위하여 근전 인터페이스를 활용하는 연구도 수행하고 있는데 두 가지 응용 연구 모두 현재 논문 심사 중에 있어 추후 동영상 등을 업데이트할 계획이다.

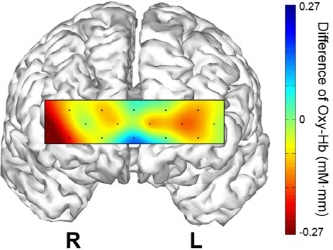

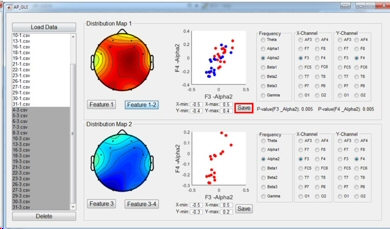

뇌파 및 생체신호를 이용한 뉴로마케팅 응용 기술 생체신호의 기계학습 분석 기반 뉴로마케팅 한양대학교 계산지능 및 뇌공학 연구실에서는 다수의 기업과의 협업을 통해 뉴로마케팅 연구를 수행하고 있다. 뉴로마케팅(neuromarketing)이란 마케팅과 관련된 자극에 대한 뇌의 반응을 연구하는 학문으로서 실제 기업에서의 제품 디자인이나 마케팅 과정에 실질적으로 활용될 수 있다. 랩에서 수행한 대표적인 뉴로마케팅 연구로는 (주)LG 전자와 수행한 "정량적 뇌파 분석을 통한 시각 피드백의 시간 지연 차이에 따른 뇌 신경 반응 연구" (주)바디프렌드와 수행한 "안마 전-후의 뇌상태 변화 모니터링 기술 개발" (주)아모레퍼시픽과 수행한 "뇌파를 이용한 뉴로마케팅 응용 기술 연구" (주)LG 전자와 수행한 "감정 치유 오디오 개발을 통한 라이팅, 특정 음원을 통한 뇌파검증" (주)현대자동차와 수행한 "무드테라피 컨셉 검증 및 감정개선 정량화 기술 연구" 등이 있다. 연구 결과는 모두 제품의 개발 과정 및 마케팅에서 중요한 정보로 활용되었다. 회사와의 협업 연구와는 별개로 생체신호, 뇌파, 근적외선분광 등의 신호 분석을 기반으로 제품에 대한 선호도를 측정하는 연구나 소비자의 의사결정 과정에서의 뇌파 및 생체신호 변화 추적 등과 같은 보다 기초적인 신경과학 레벨의 뉴로마케팅 주제들에 대해서도 활발한 연구를 수행하고 있다.

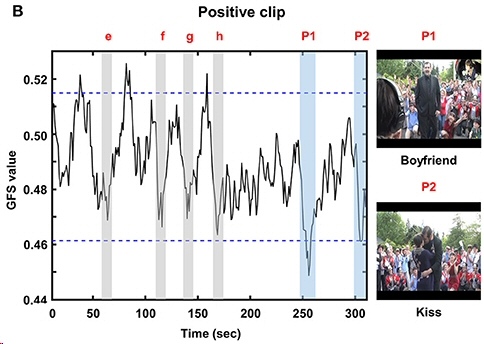

신경과학 기법을 이용한 영화 및 문화콘텐츠 연구 - 뉴로시네마틱스(Neurocinematics) 본 연구실에서는 뉴로마케팅의 한 분야인 뉴로시네마틱스(Neurocinematics) 연구도 수행하고 있는데, 이 연구의 목적은 영화 자극에 대한 뇌 반응을 살펴봄으로써 궁극적으로는 영화를 객관적으로 평가할 수 있는 새로운 척도를 개발하는 것이다(Cha et al., BCI, 2015; Shin et al., PLoS ONE, 2015). 아래 왼쪽 그림은 영화('추격자')를 시청하는 동안 남녀에게서 측정된 생체신호의 시간에 따른 변화를 나타내고 있으며 오른쪽 그림은 감정을 유발하는 동영상을 시청하는 동안 다수의 시청자에게서 측정된 뇌파의 전역 동기화 지표의 변화를 추적한 결과를 나타내고 있다 (Han et al., Front. Hum. Neurosci., 2017). 이러한 지표를 활용하면 영화 및 문화콘텐츠의 효과적인 감정 유발 여부를 보다 객관적으로 평가할 수 있어 영화의 편집 과정이나 CF, 영화 예고편 등의 제작에 큰 도움이 될 수 있다. 이어진 후속 연구에서는 정상상태시각유발전위(SSVEP)를 발생시킬 수 있는 특수한 영상을 대상 콘텐츠에 삽입한 다음 SSVEP의 크기 변화를 모니터링함으로써 영상에 대한 집중도를 추적할 수 있는 새로운 뉴로시네마틱스 기술을 제안하였다 (Park et al., Front. Neuroinform., 2021). 본 연구실에서는 이 외에도 뇌파 및 다양한 생체신호를 이용하여 사용자의 감정 변화를 추적하는 새로운 기술을 개발하기 위해 다양한 영상 자극을 활용하고 있다.

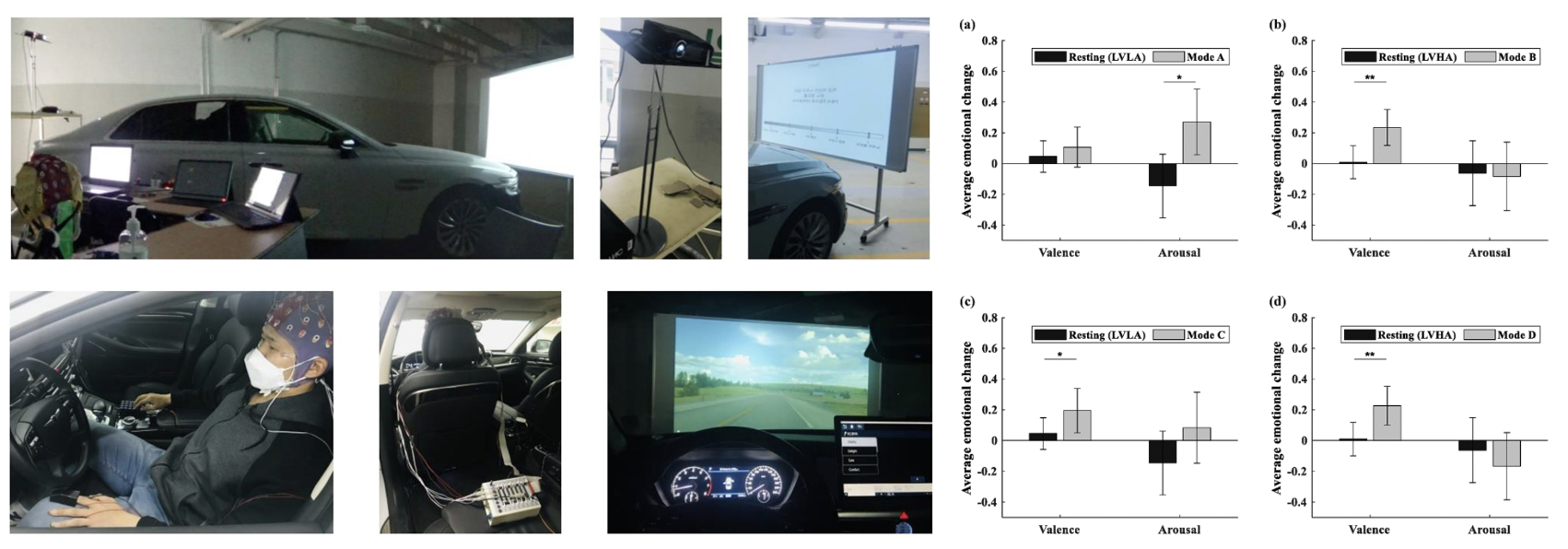

기계학습을 이용한 제품에 대한 감정 변화 및 선호도의 정량적 평가 본 연구실에서 수행하는 뉴로마케팅 기술의 차별성은 뇌파를 포함한 생체신호를 보다 정확하게 분석하기 위하여 개인별 기계학습 모델을 사전에 구축하고 실제 대상 제품에 대한 사용자 개인의 감정 변화 또는 선호도를 정량적으로 평가한다는 데 있다. 이러한 기술은 (주)현대자동차 및 (주)LG전자와 수행한 최근 산학연구에 적용되었으며 특히 (주)현대자동차와 2020년에 수행한 연구는 Affective Computing 분야의 최고 학술지인 IEEE Transactions on Affective Computing지에 게재되었다 (Kim et al., IEEE Affect. Comput., 2022) (기사 링크). 아래 그림은 현대자동차의 2022년식 G90에 탑재된 무드큐레이터(Mood Curator) 시스템의 감정개선 효과를 정량화한 연구의 연구 수행 환경 및 대표 결과를 보여주고 있다.

<현대자동차 G90에 탑재된 무드큐레이터 시스템의 감정 개선 효과 정량 분석 (Kim et al., IEEE Trans. Affect. Comput., 2022)> |

2011 (c) All rights are reserved. Computational NeuroEngineering Laboratory, Hanyang University